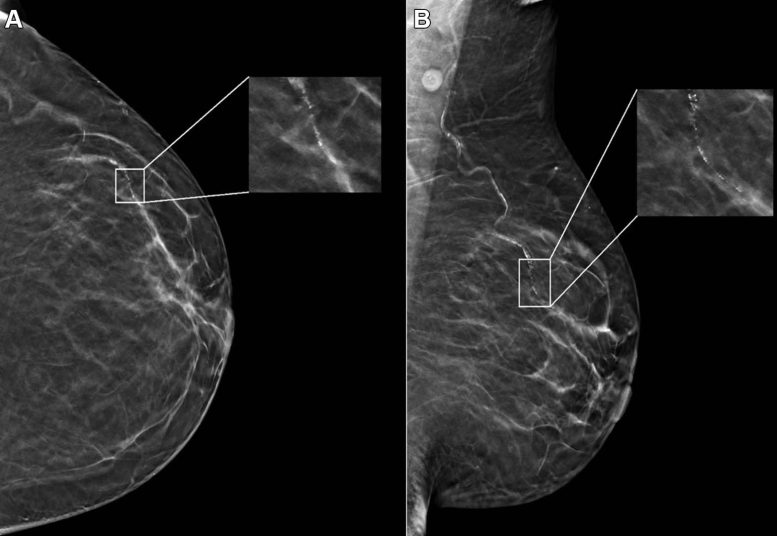

Exemplo de mamografia atribuiu uma pontuação de caso falso positivo de 96 em uma paciente negra de 59 anos com densidade mamária fibroglandular dispersa. (A) As visualizações craniocaudal esquerda e (B) oblíqua mediolateral demonstram calcificações vasculares no quadrante superior externo na profundidade média (caixa) que foram singularmente identificadas pelo algoritmo de inteligência artificial como um achado suspeito e atribuídas a uma pontuação de lesão individual de 90. Isso resultou em uma pontuação geral de caso atribuída à mamografia de 96. Crédito: Sociedade Radiológica da América do Norte (RSNA)

A pesquisa revela que a IA na mamografia pode produzir falsos positivos influenciados pela idade e raça do paciente, ressaltando a importância de diversos dados de treinamento.

Um estudo recente, que analisou quase 5.000 mamografias de rastreio interpretadas por um algoritmo de IA aprovado pela FDA, descobriu que características dos pacientes como raça e idade impactaram a taxa de falsos positivos. As descobertas foram publicadas hoje (21 de maio) em Radiologiaum jornal da Sociedade Radiológica da América do Norte (RSNA).

“A IA tornou-se um recurso para os radiologistas melhorarem a sua eficiência e precisão na leitura de mamografias de triagem e ao mesmo tempo atenuar o esgotamento do leitor”, disse Derek L. Nguyen, MD, professor assistente da Duke University em Durham, Carolina do Norte. “No entanto, o impacto das características dos pacientes no desempenho da IA não foi bem estudado.”

Desafios na aplicação de IA

Nguyen disse que embora os dados preliminares sugiram que os algoritmos de IA aplicados aos exames de mamografia de rastreio podem melhorar o desempenho diagnóstico dos radiologistas para a detecção do cancro da mama e reduzir o tempo de interpretação, há alguns aspectos da IA a ter em conta.

“Existem poucos bancos de dados demograficamente diversos para treinamento de algoritmos de IA, e o FDA não exige conjuntos de dados diversos para validação”, disse ele. “Devido às diferenças entre as populações de pacientes, é importante investigar se o software de IA pode acomodar e funcionar no mesmo nível para diferentes idades, raças e etnias de pacientes.”

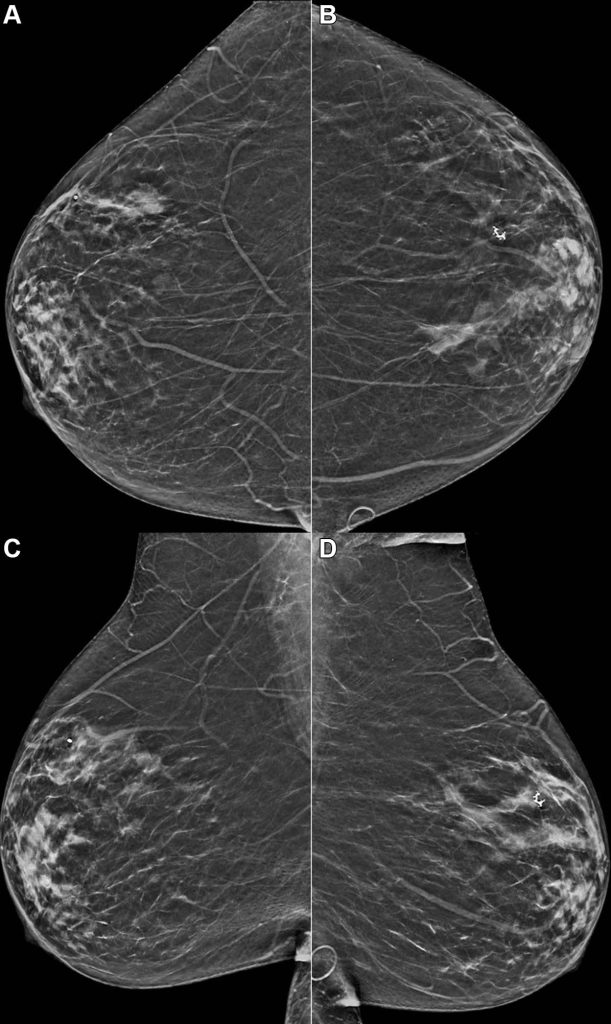

A mamografia de exemplo atribuiu uma pontuação de risco falso positivo de 1,0 em uma paciente hispânica de 59 anos com mamas heterogeneamente densas. São mostradas visualizações bidimensionais bidimensionais (A, B) craniocaudal e (C, D) oblíquas mediolaterais reconstruídas bilaterais. O algoritmo previu câncer dentro de 1 ano, mas esse indivíduo não desenvolveu câncer ou atipia dentro de 2 anos após a mamografia. Crédito: Sociedade Radiológica da América do Norte (RSNA)

Desenho do estudo e dados demográficos

No estudo retrospectivo, os pesquisadores identificaram pacientes com exames de triagem de tomossíntese mamária digital negativos (sem evidência de câncer) realizados no Duke University Medical Center entre 2016 e 2019. Todas as pacientes foram acompanhadas por um período de dois anos após as mamografias de triagem, e nenhuma paciente foram diagnosticados com câncer de mama.

Os pesquisadores selecionaram aleatoriamente um subconjunto deste grupo composto por 4.855 pacientes (idade média de 54 anos) amplamente distribuídos por quatro grupos étnicos/raciais. O subconjunto incluiu 1.316 (27%) pacientes brancos, 1.261 (26%) negros, 1.351 (28%) asiáticos e 927 (19%) hispânicos.

Um algoritmo de IA disponível comercialmente interpretou cada exame no subconjunto de mamografias, gerando uma pontuação de caso (ou certeza de malignidade) e uma pontuação de risco (ou risco de malignidade subsequente a um ano).

Desempenho de IA em dados demográficos

“Nosso objetivo era avaliar se o desempenho de um algoritmo de IA era uniforme entre idade, tipos de densidade mamária e diferentes raças/etnias dos pacientes”, disse o Dr. Nguyen.

Dado que todas as mamografias do estudo foram negativas para a presença de cancro, qualquer coisa sinalizada como suspeita pelo algoritmo foi considerada um resultado falso positivo. Os resultados de casos falsos positivos foram significativamente mais prováveis em pacientes negros e mais velhos (71-80 anos) e menos prováveis em pacientes asiáticos e pacientes mais jovens (41-50 anos) em comparação com pacientes brancos e mulheres com idades entre 51 e 60 anos.

“Este estudo é importante porque destaca que qualquer software de IA adquirido por uma instituição de saúde pode não ter um desempenho igual em todas as idades, raças/etnias e densidades mamárias dos pacientes”, disse o Dr. “No futuro, acho que as atualizações de software de IA devem se concentrar em garantir a diversidade demográfica.”

Considerações para prestadores de cuidados de saúde

Nguyen disse que as instituições de saúde devem compreender a população de pacientes que atendem antes de adquirir um algoritmo de IA para triagem, interpretação de mamografia e perguntar aos fornecedores sobre o treinamento de seu algoritmo.

“Ter um conhecimento básico da demografia da sua instituição e perguntar ao fornecedor sobre a diversidade étnica e etária dos seus dados de treinamento ajudará você a compreender as limitações que enfrentará na prática clínica”, disse ele.

Referência: “As características do paciente impactam o desempenho do algoritmo de IA na interpretação de estudos de tomossíntese mamária digital de triagem negativa” por Dr. Nguyen, Yinhao Ren, Ph.D., Tyler M. Jones, BS, Samantha M. Thomas, MS, Joseph Y. Lo , Ph.D., e Lars J. Grimm, MD, MS, 21 de maio de 2024, Radiologia.